当涉及语言模型的本地扩展时,每个人的第一个反应都应该易于赚钱和图形卡。就像Shichao的旧计算机一样,当它碰到大声笑时,它将是一个嗡嗡声。

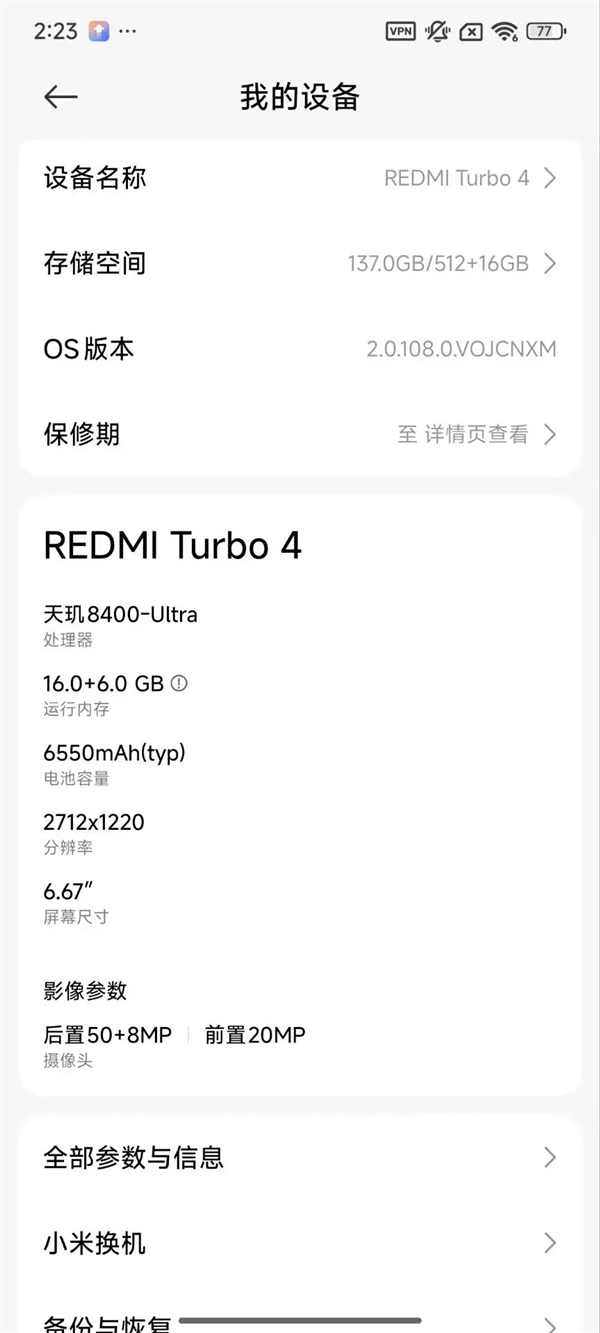

当涉及语言模型的本地扩展时,每个人的第一个反应都应该易于赚钱和图形卡。就像Shichao的旧计算机一样,当它碰到大声笑时,它将是一个嗡嗡声。可以说,前古董打破了我的梦想AI。嘿,有什么办法可以在不进食调整和金钱的情况下感受到当地AI扩展的享受?有些兄弟,有些。 Shichao的Redmi Turbo4的价格低于2,000元,可以成功部署最新的小米语言模型MIMO-7B音量版本。在完全粘附的网络的情况下,它还可以通过Word输出正确的单词结果。众所周知,Shichao总是想到他的朋友,因此他来给您一个护士级教程,包括两种方法。如果没有马车舞,请准备好冻结您的手!第一个过程是下载PocketPal AI,该应用程序专用于手机上的AI模型。打开它后,单击下载模型,单击右下角的 +符号cOrner,从拥抱面中选择添加,然后搜索MIMO,然后仅选择要下载的第一个版本。我不会选择一个,因为背部越大,模型的准确性越高,这对于我们的手机来说确实很难。最后,返回主页,然后单击“选择模型”以选择要开始聊天的模型。如果您觉得很困难,Shichao还准备了一个更简单的过程,并将此URL直接插入浏览器:https://github.com/alibaba/alibaba/mnn/mante/master/master/master/project/proign/proign/proid/proid/android/android/android/andapps/mnllmmapp,这是一个End-Cide多态模型模型Dopplyment Platform Platform Platform Platform Platform bi biialibababibaba bialibaba's。向下滑动以发布,单击下载,下载此应用,您可以选择和下载要体验的本地模型,也可以运行稳定的扩散。 。好的,扩展完成了,让我们向所有人展示结果。当那天下班,不小心走到亚马逊的雨林时,他失踪了。没有信号。我认为他无法生存。 。所以我立即抓住了我的Mimo,问他如何钻木头以开火。在不到三分钟的时间里,他为我写了一切。在这里,我们的小型模型的独特优势被充分显示 - 随时随地在任何地方忽略了环境和在本地操作。直接奔向您的手机,即使在雪,沙漠,海洋甚至星系覆盖的山上,我们都可以随时随地兼顾这个私人助手。那么,如果有点呢?在仅由阿里巴巴发布的QWEN3中,只有一个只有0.6B参数的模型。我们还用他们自己的MNN尝试了它。嗯。 。他可以说话,但他说的话似乎有点深。 。但是,它应该与手机扩展有关。 MNN型号通常对移动电话扩展进行特殊优化,以防止手机崩溃。这对于某些模型精度消失是正常的。这种情况只是一个概率事件。但是,有了这些小型模型,无论我们走到哪里,我们都可以与AI聊天乌特(Uture),如果我乘坐太空飞船前往火星,我绝对不会被砸死。有人说,你很复杂。你可以去生命的间距吗?现在没有互联网?哪些大型应用程序不好?但是,使用小型型号实际上是更多。如果AI想更靠近我们的生活,那应该是一个较小的模型。如果AI发展到您进入房屋的地步,您突然想在沙发上观看电视,并要求AI帮助您 - 电视。这真的只是一份工作。但是,如果您在大型模型的命令下更换所有工具,则必须等待它们上传数据,深入思考,然后还原数据。我认为您在电视打开之前就在一个简短的视频中。这是较少参数的另一个优点 - 低延迟。没有这么多参数,就无需考虑这么多事情并完全遵守主命令。此外,较小的MGA参数,培训和扩展的成本较低。据说在GP上培训T-4O水平的模型有时会燃烧1亿美元,而平民将无法制作大型模型。因此,每次AI公司打开新模型时,它都会发布不同的尺寸,使每个人都可以自由选择适合它们的模型。许多小公司是现场领域的专家,不需要百科全书,例如大型模型。具有最小参数的模型可用于公司从各行各业中训练。他们不仅可以花费更少的钱,还可以在该领域创建专家。如今,许多专业模特在他们的领域变得明亮而温暖。尽管Du Xiaoman财务模型的Xuanyuan-6b仅为6B,但效果非常好。在许多金融领域,例如认证的公共会计师(CPA),银行资格,资金资格和安全资格,这件事可以显示金融领域专家的水平。如今,许多公司也开始在小型模型上做出全面的努力,许多车型W较少的参数可以与大型模型相提并论。像我们的DeepSeek一样,我们使用一些新颖的算法来防止具有更少参数的模型性能。 DeepSeek-R1-Distill的7b和14b版本可以超过数学识别活动中的许多封闭源模型。还有一家名为Weimian Intelligent的公司。他们专注于端侧模型,其针对移动设备(例如手机和计算机)。他们创建的“小钢制大炮”微型PM仅为8B,其测试性能与GPT-4O相当。此外,它们在小型型号中长期填充了多模式的功能,实现了整个模式的端到端。甚至苹果也开始开发自己的3B参数模型。他们的AFM-on-nevice比Gemma,Phi-3 mini和其他具有更大参数的模型具有更好的结果。然后问题又来了。这些模型具有最小的参数,并且可以满足大型模型。为什么?这些小东西真的有独特的秘密。例如,知识知识的方法就像要求老师给学生进行小型培训,并允许大型模型通过他们学到的知识和经验。简而言之,除了修剪,音量和其他过程外,这是为了改变模型中的高精度计算,而无需高精度。进行低决定计算,以便模型可以更快地运行。去年,由Nvidia和Meta发布的Llama-3.1 Minitron 4B AI模型从原始的8B型号中进行了修剪,从而使节省更快,更多的资源。最后的最后一步称为混合专家模型(MOE)。传统的大型模型就像一个专家团队一起工作。无论问题是什么,整个小组都必须寻找男人。 Moe的建筑角色是将该小组由专家分为专业团体:有些专门从事数学推导,有些专门研究仪式,有些人负责用于识别图像。 。这样,当您遇到小问题时,您不必“整体工作”。因此,即使这些模型很小,它们也可能是迈向AI世界的又一重要一步。正如尚未在一夜之间实现技术发展一样,我们正在等待普通百姓果实。

当涉及语言模型的本地扩展时,每个人的第一个反应都应该易于赚钱和图形卡。就像Shichao的旧计算机一样,当它碰到大声笑时,它将是一个嗡嗡声。可以说,前古董打破了我的梦想AI。嘿,有什么办法可以在不进食调整和金钱的情况下感受到当地AI扩展的享受?有些兄弟,有些。 Shichao的Redmi Turbo4的价格低于2,000元,可以成功部署最新的小米语言模型MIMO-7B音量版本。在完全粘附的网络的情况下,它还可以通过Word输出正确的单词结果。众所周知,Shichao总是想到他的朋友,因此他来给您一个护士级教程,包括两种方法。如果没有马车舞,请准备好冻结您的手!第一个过程是下载PocketPal AI,该应用程序专用于手机上的AI模型。打开它后,单击下载模型,单击右下角的 +符号cOrner,从拥抱面中选择添加,然后搜索MIMO,然后仅选择要下载的第一个版本。我不会选择一个,因为背部越大,模型的准确性越高,这对于我们的手机来说确实很难。最后,返回主页,然后单击“选择模型”以选择要开始聊天的模型。如果您觉得很困难,Shichao还准备了一个更简单的过程,并将此URL直接插入浏览器:https://github.com/alibaba/alibaba/mnn/mante/master/master/master/project/proign/proign/proid/proid/android/android/android/andapps/mnllmmapp,这是一个End-Cide多态模型模型Dopplyment Platform Platform Platform Platform Platform bi biialibababibaba bialibaba's。向下滑动以发布,单击下载,下载此应用,您可以选择和下载要体验的本地模型,也可以运行稳定的扩散。 。好的,扩展完成了,让我们向所有人展示结果。当那天下班,不小心走到亚马逊的雨林时,他失踪了。没有信号。我认为他无法生存。 。所以我立即抓住了我的Mimo,问他如何钻木头以开火。在不到三分钟的时间里,他为我写了一切。在这里,我们的小型模型的独特优势被充分显示 - 随时随地在任何地方忽略了环境和在本地操作。直接奔向您的手机,即使在雪,沙漠,海洋甚至星系覆盖的山上,我们都可以随时随地兼顾这个私人助手。那么,如果有点呢?在仅由阿里巴巴发布的QWEN3中,只有一个只有0.6B参数的模型。我们还用他们自己的MNN尝试了它。嗯。 。他可以说话,但他说的话似乎有点深。 。但是,它应该与手机扩展有关。 MNN型号通常对移动电话扩展进行特殊优化,以防止手机崩溃。这对于某些模型精度消失是正常的。这种情况只是一个概率事件。但是,有了这些小型模型,无论我们走到哪里,我们都可以与AI聊天乌特(Uture),如果我乘坐太空飞船前往火星,我绝对不会被砸死。有人说,你很复杂。你可以去生命的间距吗?现在没有互联网?哪些大型应用程序不好?但是,使用小型型号实际上是更多。如果AI想更靠近我们的生活,那应该是一个较小的模型。如果AI发展到您进入房屋的地步,您突然想在沙发上观看电视,并要求AI帮助您 - 电视。这真的只是一份工作。但是,如果您在大型模型的命令下更换所有工具,则必须等待它们上传数据,深入思考,然后还原数据。我认为您在电视打开之前就在一个简短的视频中。这是较少参数的另一个优点 - 低延迟。没有这么多参数,就无需考虑这么多事情并完全遵守主命令。此外,较小的MGA参数,培训和扩展的成本较低。据说在GP上培训T-4O水平的模型有时会燃烧1亿美元,而平民将无法制作大型模型。因此,每次AI公司打开新模型时,它都会发布不同的尺寸,使每个人都可以自由选择适合它们的模型。许多小公司是现场领域的专家,不需要百科全书,例如大型模型。具有最小参数的模型可用于公司从各行各业中训练。他们不仅可以花费更少的钱,还可以在该领域创建专家。如今,许多专业模特在他们的领域变得明亮而温暖。尽管Du Xiaoman财务模型的Xuanyuan-6b仅为6B,但效果非常好。在许多金融领域,例如认证的公共会计师(CPA),银行资格,资金资格和安全资格,这件事可以显示金融领域专家的水平。如今,许多公司也开始在小型模型上做出全面的努力,许多车型W较少的参数可以与大型模型相提并论。像我们的DeepSeek一样,我们使用一些新颖的算法来防止具有更少参数的模型性能。 DeepSeek-R1-Distill的7b和14b版本可以超过数学识别活动中的许多封闭源模型。还有一家名为Weimian Intelligent的公司。他们专注于端侧模型,其针对移动设备(例如手机和计算机)。他们创建的“小钢制大炮”微型PM仅为8B,其测试性能与GPT-4O相当。此外,它们在小型型号中长期填充了多模式的功能,实现了整个模式的端到端。甚至苹果也开始开发自己的3B参数模型。他们的AFM-on-nevice比Gemma,Phi-3 mini和其他具有更大参数的模型具有更好的结果。然后问题又来了。这些模型具有最小的参数,并且可以满足大型模型。为什么?这些小东西真的有独特的秘密。例如,知识知识的方法就像要求老师给学生进行小型培训,并允许大型模型通过他们学到的知识和经验。简而言之,除了修剪,音量和其他过程外,这是为了改变模型中的高精度计算,而无需高精度。进行低决定计算,以便模型可以更快地运行。去年,由Nvidia和Meta发布的Llama-3.1 Minitron 4B AI模型从原始的8B型号中进行了修剪,从而使节省更快,更多的资源。最后的最后一步称为混合专家模型(MOE)。传统的大型模型就像一个专家团队一起工作。无论问题是什么,整个小组都必须寻找男人。 Moe的建筑角色是将该小组由专家分为专业团体:有些专门从事数学推导,有些专门研究仪式,有些人负责用于识别图像。 。这样,当您遇到小问题时,您不必“整体工作”。因此,即使这些模型很小,它们也可能是迈向AI世界的又一重要一步。正如尚未在一夜之间实现技术发展一样,我们正在等待普通百姓果实。